Stratège marketing de contenu

Est-il possible de prédire la position d’une page dans Google?

Stratège marketing de contenu

En 2018, j’ai découvert, grâce à François Goube et à OnCrawl, les initiateurs des Data SEO Labs, Rémi Bacha et Vincent Terrasi. Leur mission est simple mais ambitieuse : allier SEO et science des données pour combattre la toute-puissance de RankBrain, le premier algorithme de Google capable de comprendre les intentions de recherche d’un utilisateur et d’afficher des résultats personnalisés en temps réel. Pour mener à bien cette mission, ils ont décidé de tenter de prédire le plus justement possible les chances d’une page de se positionner en première page de Google. Grâce à la science de données, leur taux de réussite atteint jusqu’à 90%.

Le SEO en 2020

L’arrivée de RankBrain en 2015 a modifié le fonctionnement du moteur de recherche de Google. Avant, les critères de référencement étaient définis, testés et analysés par des humains. Selon Backlinko (et son super guide sur Rankbrain), cela ressemblait à ceci :

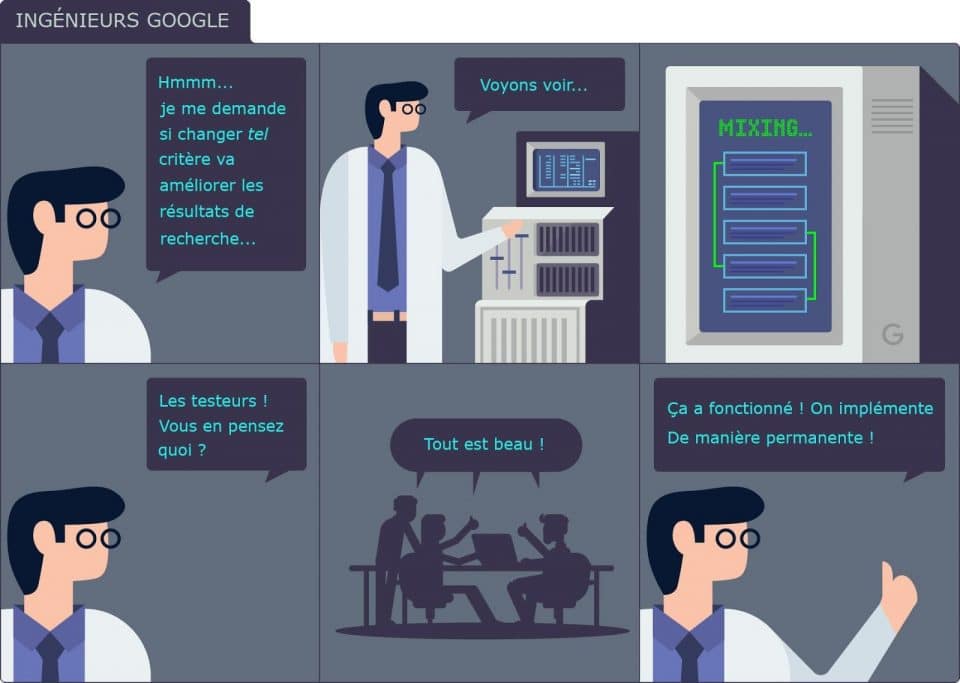

Même si l’intervention humaine est toujours nécessaire, comme en témoigne les fameuses Quality Raters Guidelines utilisées par les Quality Raters chargés d’évaluer la pertinence de certains résultats de recherche (ou de tests d’amélioration), elle l’est de moins en moins. Qui plus est, le fonctionnement de l’algorithme change selon la requête et s’adapte à l’utilisateur. Des dizaines de micro-changements (ou ajustements) sont apportés tout au long de l’année sans que l’on s’en rende nécessairement compte :

RankBrain bouleverse les habitudes en matière de SEO :

- Changement des facteurs connus et de leur importance (qualité par rapport à quantité en ce qui concerne le linkbuilding par exemple)

- Émergence de nouveaux facteurs (EAT et mobile first indexing en 2018)

- Erreurs d’indexation, comme celle qui a touché Search Engine Land fin 2018

- Ultrapersonnalisation des résultats de recherche selon l’historique de recherche ou la localisation d’un utilisateur

- Facteurs de positionnement adaptés à la requête ou à l’industrie

C’est encore plus vrai avec l’arrivée fin octobre de BERT, pour le moment uniquement en anglais, qui permet de comprendre le langage “naturel” des internautes. L’objectif de BERT est de mieux comprendre les relations entre les mots d’une phrase, plutôt que de traiter les expressions et les mots un par un. Google cherche ainsi à déterminer le sens précis de requêtes parfois très précises, où l’usage de certains mots de liaison peut changer drastiquement le sens de la recherche, par exemple lorsqu’une négation est utilisée.

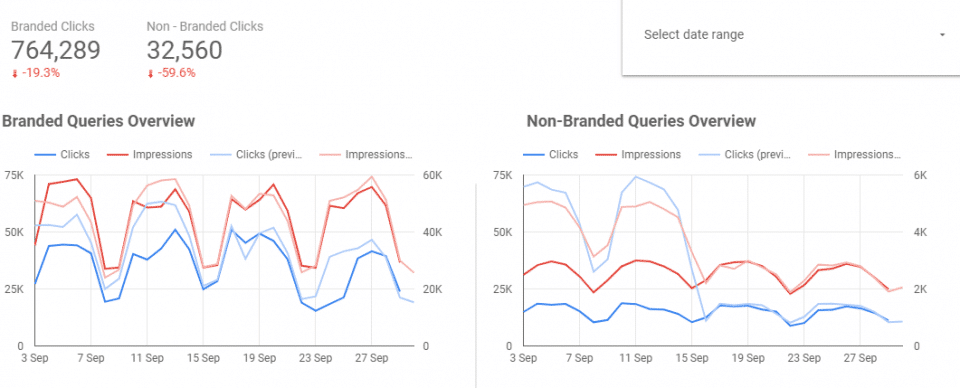

Il devient de plus en plus difficile et fastidieux de disposer d’une bonne vision d’ensemble de l’état de santé et du positionnement SEO d’un site. Les vétérans se souviennent encore des jours où Google Analytics a cessé de montrer les requêtes en les remplaçant par « not provided ». Pour ma part, ce fut la panique lorsque Google a pris la décision de ne plus afficher les requêtes anonymes dans Google Search Console en août 2018. J’en garde un souvenir assez traumatisant et je vous laisse imaginer ma tête lorsqu’il a fallu que j’enquête pour un client à la suite de ces résultats :

En fait, le trafic était toujours là, l’information avait simplement été retirée de la Search Console…

Ces dernières années, on constate aussi une multiplication des outils nécessaires pour accomplir un bon travail en matière de SEO, Google étant de plus en plus avare sur ce plan. Analyse de liens, analyse sémantique, analyse de la performance du site, analyse des logs, recherche de mots clés, recherche de sujets de contenu performant, analyse du positionnement, analyse de la concurrence, crawler… Une agence SEO utilise en moyenne de 10 à 20 outils pour effectuer son travail. Il est désormais fortement recommandé de tendre vers l’automatisation de tâches susceptibles de nécessiter plusieurs jours, voire semaines, et de trouver un moyen de faire en sorte que tous ces différents outils communiquent entre eux. Et cela est d’autant plus important à l’heure du Big Data et des 3V : volume, vélocité et variété.

Comprendre le présent pour prédire l’avenir

Durant ma formation avec Rémi et Vincent, on m’a raconté une anecdote intéressante. Lors d’un SEO Camp, un sondage a été effectué. On interrogeait des spécialistes SEO juniors, intermédiaires et seniors sur les probabilités qu’une page donnée se place sur la première page de résultats d’une requête donnée. Environ 25 % des juniors, 33 % des intermédiaires et 40 % des seniors ont trouvé la bonne réponse. Conclusion : un bon vieux pile ou face aurait plus de chances qu’un spécialiste SEO de prédire correctement le positionnement d’une page.

Si de nombreux débats existent dans le monde du SEO sur l’importance et le poids des facteurs de positionnement, les plus importants sont connus et font consensus. Il ne reste plus dès lors qu’à trouver une méthodologie permettant d’analyser le poids de ces facteurs et l’importance variable qu’ils ont en fonction d’une industrie, le tout à partir d’un volume de pages impossibles à analyser pour un humain. En somme, plutôt que de se reposer uniquement sur l’empirisme d’un spécialiste SEO, utiliser la science de données, l’ingénierie inversée et le machine learning pour l’aider à prédire correctement le positionnement d’une page.

Cette méthodologie existe et se base sur l’utilisation de Dataiku. Rémi et Vincent ont bâti un processus semi-automatisé qui leur permet, par exemple, d’analyser les éléments suivants pour un site donné :

- 100 premiers résultats de recherche sur X requêtes (10 000, 20 000…)

- Crawl des 100 pages correspondant à ces requêtes

- Récupération du profil de backlinks des X URL analysées

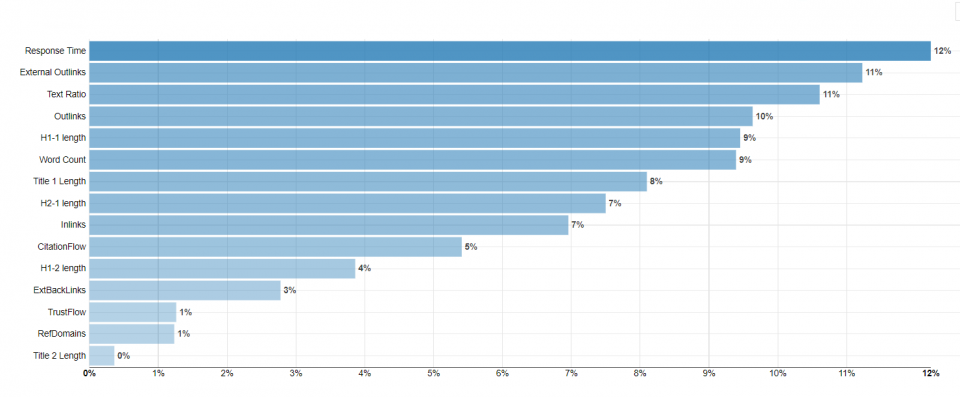

Une fois le tout récupéré et regroupé dans un gigantesque fichier aux milliers de lignes, il « suffit » ensuite de passer au crible ce dernier en utilisant (aussi de façon automatisée) plusieurs méthodes de calcul (forêt aléatoire, régression linéaire, XGBoost). Celles-ci offrent différents taux de réussite en fonction des critères SEO analysés et des questions posées (par exemple : quels sont les critères de positionnement importants dans cette industrie ? Après sa mise en ligne, ma page en préproduction a-t-elle une chance de se positionner en première page d’une requête?). Cette méthodologie offre un taux de réussite pouvant atteindre 90 %. On se rapproche donc de très près du fonctionnement de l’algorithme de Google et, surtout, on prend des décisions SEO éclairées fondées sur l’analyse d’un grand volume de mots clés. Tout critère utilisé par Google peut ainsi être potentiellement analysé et mesuré du moment qu’il peut être crawlable.

- Vitesse du site

- Nombre de liens entrants et qualité de ceux-ci

- Text Ratio

- Fraîcheur du contenu

- Présence du mot clé dans les différentes balises et le contenu

- Niveau dans l’arborescence

- etc.

Rapidement, il est donc possible de déterminer avec une grande précision quels sont les critères à attaquer en priorité pour améliorer le positionnement d’un site Web dans une industrie donnée. Comme ici :

Il y a presque deux ans, lorsque j’ai découvert la conférence de Rémi et Vincent durant laquelle ils présentaient leur méthodologie, j’étais sceptique, mais fasciné par la précision avec laquelle ils parvenaient à « comprendre » RankBrain. Aujourd’hui,toujours aussi fasciné par le potentiel de cette méthodologie, je suis convaincu que c’est la voie à suivre : comprendre le présent pour prédire l’avenir.