Conseils SEO pour faciliter l’accessibilité à votre contenu

Depuis les derniers mois, on entend beaucoup parler de la mise à jour Panda de Google pour contrer la prolifération des content farm. De plus, on a remarqué de fortes pénalités accordées à JC Penney et d’autres sites pour des pratiques douteuses. Pendant que l’achat de liens continue à faire jaser, c’est probablement l’importance des signaux sociaux dans l’algorithme qui est le sujet chaud en ce moment.

Il est clair que des nouveaux facteurs sont en jeu et que les signaux de popularité importants pour les moteurs de recherche vont continuer d’évoluer avec le comportement des internautes. Toutefois, on oublie trop souvent que le référencement en 2011 reste assez semblable au référencement web d’il y a cinq ans sur plusieurs points.

Avant de réfléchir aux meilleures stratégies de popularité, il est bénéfique de s’assurer que les éléments on-site de votre site sont au point. Il semble que plusieurs sautent des étapes importantes de la base d’un bon référencement.

1 – Est-ce que les crawlers ont facilement accès au contenu de votre site ?

Je ne parle pas de fichier robots.txt ou de l’utilisation de JavaScript, mais d’éléments plus spécifiques qui sont parfois omis.

Voici quelques pistes pour optimiser l’accessibilité de votre contenu.

- Assurez-vous de n’avoir aucune erreur dans le sitemap.xml et que toutes les URL sont présentes.

- Assurez-vous de ne pas dupliquer votre page d’accueil avec l’utilisation d’une page /index.html. Si c’est le cas, ajoutez une redirection 301 de la page www.nomdusite.ca/index.html vers www.nomdusite.ca. Il est important de concentrer vos efforts sur la vraie page d’accueil, car elle reçoit la grande majorité des liens entrants sur votre domaine.

- Assurez-vous de faire une bonne utilisation des répertoires de langues /fr et /en.

- Pour les sites de nouvelles, assurez-vous d’avoir un sitemap.xml pour Google News. Une bonne présence sur le vertical Google News peut générer du trafic fort intéressant.

- Si vous misez sur les vidéos et que vous voulez les positionner sur les moteurs de recherche, assurez-vous d’avoir un sitemap.xml spécifique aux vidéos.

- Assurez-vous de faire une bonne utilisation des liens internes. L’idée est d’ajouter des liens pertinents pour l’utilisateur dans le contenu de vos pages pour augmenter le crawling des pages. Dans une optique SEO, positionnez ces liens sur des termes riches en mots clés.

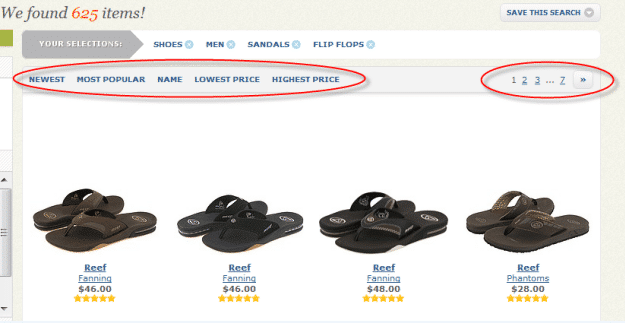

- Pour des pages générées par une base de données, assurez-vous que le link juice passe facilement vers vos fiches. D’un point de vue strictement SEO, tentez de diminuer l’utilisation de paramètre dynamique dans vos URL. Sur ce point, privilégiez des URL statiques. Vous pouvez aussi bloquer les pages générées par les filtres.

- Diminuez la profondeur des répertoires et mettre en place une stratégie pour la réécriture de vos URL. Si vous modifiez des URL, il est primordial d’effectuer des bonnes redirections 301 pour conserver l’historique et le link juice des pages.

2 – Duplication du contenu

La duplication de contenu est un problème fréquent sur plusieurs sites et un obstacle majeur au référencement. Heureusement, elle est souvent facile à régler. Voici les problèmes les plus fréquents que nous rencontrons :

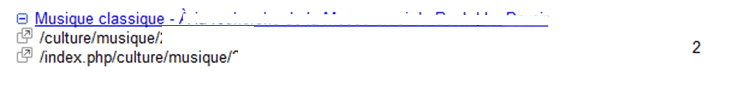

Duplication de contenu causée par le CMS

Dans cet exemple, la même page est placée à deux endroits sur le site. Or, elle ne devrait pas se retrouver dans un répertoire /index.php. Assurez-vous que votre CMS ne crée pas de duplication de page.

Duplication causée par l’architecture du contenu

Ce problème est plus fréquent sur les sites de commerce électronique. Dans notre exemple, la fiche produit « Pro model 2011 » est placée dans 3 répertoires.

- nomdusite.ca/pantalon/adviso-clothing/pro-model-2011

- nomdusite.ca/adviso-clothing/pantalon/pro-model-2011

- nomdusite.ca/nouveaute/pantalon/pro-model-2011

Vous pouvez régler ce problème avec l’utilisation de balise « rel=canonical » ou « noindex, follow », mais l’idéal est de contrer cette duplication dès le départ en proposant une architecture de contenu qui limite la duplication.

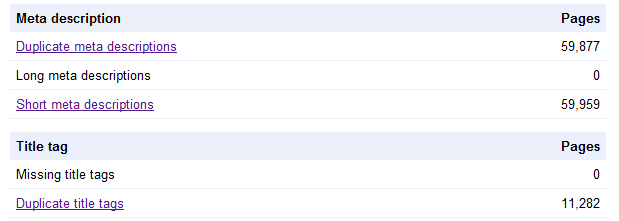

Duplication des balises TITLE et META description

Le manque de personnalisation des balises est souvent en cause. Vous pouvez régler ce problème en personnalisant chaque balise TITLE et META description ou en les générant automatiquement avec votre balise H1 ou le fil d’Ariane.

La pagination des pages et les filtres sont aussi des sources importantes de duplication de contenu, dont les balises TITLE et META description.

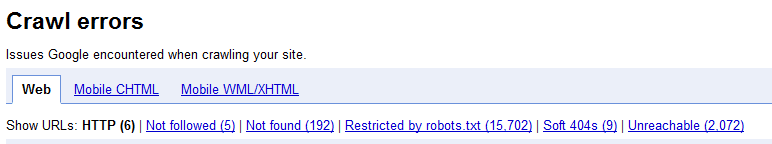

3 – Erreurs de crawling.

Les robots n’aiment pas les erreurs de serveur, that’s it that’s all. Que ce soit une page 404 ou une erreur 500, assurez-vous de diminuer au maximum vos erreurs de crawling pour faciliter la navigation des robots. Google Webmaster Tools est définitivement votre meilleur ami pour identifier les erreurs de crawling sur votre site.

Sur ce point, deux choses à effectuer :

- Régler les erreurs de crawling actuelles qui ont été causées dans le temps. La solution est souvent de rediriger les pages 404 actuelles vers les pages les plus similaires sur le site ou la page d’accueil.

- Assurez-vous d’avoir une procédure claire lorsque vous modifiez/éliminez du contenu sur votre site et que ça implique la modification d’une URL. C’est probablement la cause principale qui génère des pages 404 sur un site.

Étude de cas

Dernièrement, notre équipe de référencement a fait un travail d’optimisation semblable. En seulement un mois, nous avons des résultats forts positifs.

- Augmentation de 18 % du trafic organique hors marque

- Augmentation de la couverture des mots clés long-tail

- Amélioration des positions sur des termes génériques

Former vos nouveaux (elles) !

Point important pour les gestionnaires en marketing interactif.

Assurez-vous que vos nouveaux employés moins expérimentés ont une bonne connaissance du CMS et des meilleures pratiques de référencement. Il est souvent bénéfique de faire des courtes formations et donner des directives pour la création de liens internes, le choix des textes d’ancrage, l’utilisation des balises headers, le tagging et l’archivage des pages, l’optimisation des images et les autres aspects de base du référencement.

Sur ce, on réalise rapidement qu’il y a certains points à analyser avant de se lancer dans une stratégie de popularité. L’idée est d’avoir une base solide pour s’assurer que le contenu est facilement accessible par les robots. Le retour de vos actions de popularité sera plus grand si votre site respecte les bonnes pratiques du référencement.