6 raisons de lier sa donnée SEO à un entrepôt de données

L’arrivée de la loi 25, qui génère des impacts en marketing numérique, oblige les professionnels du marketing à faciliter le parcours client au maximum.

Désormais, la compréhension approfondie de la clientèle est beaucoup plus stratégique et importante. Cette dernière implique d’avoir une vue à 360 degrés sur la clientèle, en plus d’analyser globalement les canaux marketing utilisés.

La solution? Casser les silos de données et développer une stratégie omnicanale. La donnée propre au SEO ne fait pas exception!

Notamment, c’est dans l’optique d’unifier cette donnée 360 que les entrepôts de données ont été créés. Ils permettent par exemple de conserver toutes les données SEO et SEM au même endroit afin d’avoir une compréhension plus générale de ce qu’il se passe dans les moteurs de recherche.

Pourquoi la donnée de Google Search Console est-elle importante ?

La donnée présentée dans Google Search Console est essentielle pour activer correctement toute stratégie SEO. Ainsi, cette donnée est très prisée par les experts SEO du monde entier qui l’utilisent pour étoffer leurs analyses et leurs recommandations.

Votre compte Google Search Console contient de nombreuses informations essentielles sur l’affichage et les performances organiques de votre site, et ce, directement depuis les résultats de recherche de Google. Notamment, on y retrouve les mots-clés tapés par les utilisateurs, le nombre de clics vers votre site à partir de ces mots-clés, les impressions, les positions et les taux de clics. C’est là que réside la puissance de la donnée issue de Google Search Console : cette connexion directe avec Google permet de voir la performance organique des efforts marketing, réellement.

Les avantages d’ajouter sa donnée Google Search Console dans un entrepôt de données

1. Établir une stratégie omnicanal

Réunir toute sa donnée au même endroit permet d’avoir une vision plus complète et globale des différents canaux. Cette vision 360 permet d’activer une stratégie omnicanal plus efficace pour atteindre vos objectifs d’affaires. Il est alors plus facile de comprendre les relations entre les différents canaux afin de créer un effet de levier qui améliorera leur performance globale.

À titre d’exemple concret, l’entrepôt de données peut rendre possibles les analyses croisées avec la donnée issue de Google Ads pour la partie SEM. En ayant une vision sur les performances SEM et les performances SEO, il est possible d’ arrimer les efforts SEO et SEM pour affiner une stratégie plus globale sur les moteurs de recherche.

2. Éliminer la limite de données dans le temps

La donnée présente dans Google Search Console est limitée aux 16 derniers mois. Il est donc impossible, par exemple, de remonter cinq ans en arrière.

Sans entrepôt de données, il est plus difficile de prendre connaissance des résultats d’une stratégie SEO à travers les années, et ainsi plus complexe de déterminer les meilleures avenues à explorer dans le futur. C’est comme monter un escalier dans le noir avec une torche dans les mains : vous voyez un peu en arrière, un peu en avant, ni plus ni moins.

En investissant 0.02$ à 0.03$ par GB par mois sur BigQuery (prix au moment d’écrire ces lignes), la donnée extraite et entreposée aujourd’hui sera disponible pour toujours ou tant et aussi longtemps que l’entrepôt de données demeure actif. Il est même possible d’extraire toute cette donnée de l'entrepôt pour plutôt l’entreposer à l’extérieur du Cloud, dans un fichier CSV sur un ou plusieurs disques durs. En analysant les données historiques, il est possible de faire de l’exploration de données (data mining) pour extraire des connaissances et informer les décisions futures.

Utiliser le passé pour prévoir le futur.

Lâcher la torche et ouvrir la lumière.

Attention! La donnée récupérée n’est pas rétroactive. Il est donc primordial de mettre en place cette connexion avec l’entrepôt de données le plus rapidement possible afin d’entamer la collecte de données.

3. Diminuer (voire éliminer !) les contraintes liées à la limite de données extraites grâce à BigQuery

L’exportation de la donnée via Google Search Console directement est limitée à 1 000 lignes de données par exportation, ce qui peut parfois être très limitatif. Si vous récupérez cette donnée via l’API Search Analytics vers un entrepôt de données, la limite est plutôt de 50,000 lignes par jour, ce qui est généralement largement suffisant pour faire des analyses intéressantes et qui ont de l’impact.

Une seule exception existe : avec une connexion directement depuis BigQuery, il n’y a pas de limite technique de données extraites par jour! La seule limite est la capacité de récolte de votre compte BigQuery, qui est dictée par les investissements que vous voulez bien y faire.

4. Simplifier le Reporting omnicanal

En réunissant les données dans un entrepôt, il est plus simple de les connecter directement dans des tableaux de visualisation pour vos Dashboards. Ainsi, il n’est plus nécessaire de connecter plusieurs sources de données aux tableaux. Il suffit de brancher votre entrepôt de données et le tour est joué!

Pour reprendre l’exemple de BigQuery, il peut être connecté directement à Looker Studio (anciennement Google Data Studio) pour produire des rapports dynamiques qui comprennent la performance de tous vos canaux dans une même fenêtre.

5. Posséder la donnée à part entière

Un autre avantage d’exporter la donnée dans un entrepôt est de la posséder entièrement, et donc de pouvoir l’accumuler. Grâce aux exportations de données non contraignantes et à l’inexistence d’une limite avec l’historique de la donnée, pour quelques dollars par mois, vous êtes libre de manipuler votre propre donnée comme bon vous semble. C’est un peu comme avoir un fichier CSV, mais avec potentiellement des milliards de lignes, que vous pouvez filtrer, regrouper, pivoter, joindre, altérer, supprimer, etc., à votre guise.

La donnée vous appartient : vous en faites ce que vous voulez.

6. Automatiser facilement le processus d’entreposage de la donnée Google Search Console avec BigQuery

Il existe aujourd’hui des connecteurs qui peuvent être installés facilement pour récolter de manière automatique et continue la donnée de Google Search Console, pour l’ajouter dans un entrepôt de données. Le plus connu et le plus facile d’intégration est le connecteur natif dans Google Search Console vers BigQuery qui a été intégré directement dans Google Search Console en février 2023.

On vous explique ci-dessous comment faire.

Comment connecter sa donnée Google Search Console (GSC) à BigQuery ?

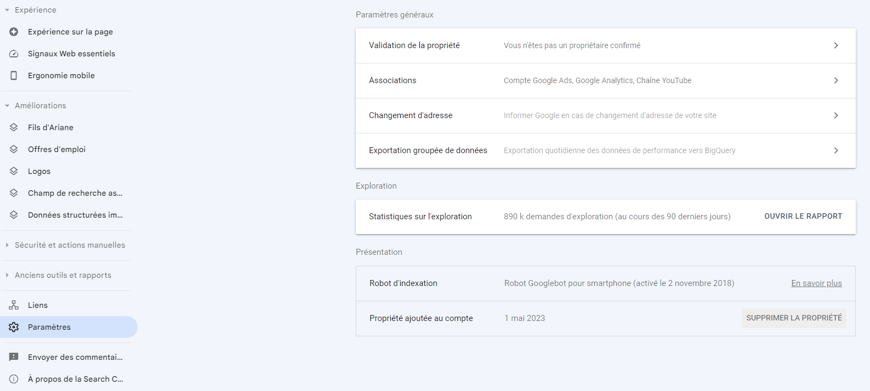

Pour commencer, rendez-vous dans les paramètres à gauche dans votre propriété Search Console :

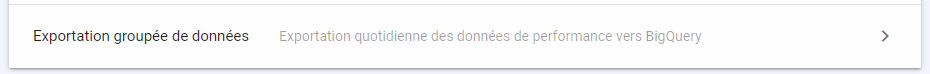

Ensuite, cliquez sur « Exportation groupée de données »:

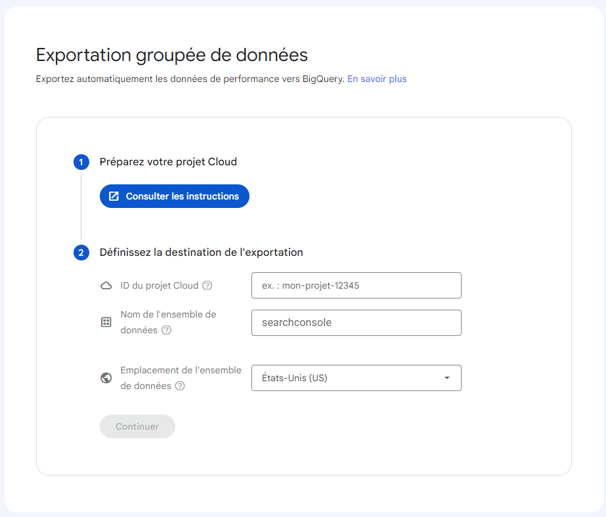

Deux étapes se présentent à vous.

Étape 1 - Suivez la première étape comme indiqué dans le lien fourni pour préparer votre projet Cloud

Lancer une nouvelle exportation groupée de données - Aide Search Console

Étape 2 - Renseignez les champs demandés

ID du projet : à votre discrétion.

Nom de l’ensemble de données : laissez la valeur par défaut searchconsole

Note : Si vous avez plus d’une propriété GSC, utilisez un suffixe pour vous aider à identifier les exportations, par exemple searchconsole_adviso_ca et searchconsole_adviso_com pour identifier les exportations de adviso.ca et adviso.com (par exemple)

Emplacement de l’ensemble de données : à définir avec votre équipe technique et légale. Dans le doute, une entreprise québécoise va généralement choisir Montréal.

Étape 3 - Cliquez sur « Continuer », puis « Oui »

Après 48h, vos données devraient apparaître dans BigQuery.

Terminé! Vous avez connecté votre donnée Search Console à BigQuery avec succès.

Et dans le cas d’autres entrepôts de données ?

Nous avons mis l’exemple de BigQuery dans cet article, mais il existe plusieurs autres solutions pour entreposer vos données afin d’en faire des analyses. En effet, il existe une quantité étourdissante de solutions d’intelligence artificielle, de Machine Learning et d’entreposage de données.

Un rapide coup d'œil sur la page The 2023 MAD (ML/AI/Data) Landscape pourrait vous donner le vertige. Si on devait n’en nommer que quelques-uns, Snowflake, Amazon RedShift, Azure Synapse et Databricks seraient de bons exemples d’entrepôts de données qui ont tous leurs spécificités, avantages et inconvénients, et qui conviennent à différents types de cas. Cependant, ces autres entrepôts de données n’ont pas de connexion native avec Google Search Console. Vous devrez donc utiliser l'API Google Search Console pour y exporter les données, tout en considérant les limitations additionnelles de l'API par rapport à l'exportation native.

En effet, si vous voulez éviter les limitations de l'API et garder votre entrepôt Snowflake, par exemple, vous devrez utiliser l'exportation native de Google Search Console vers BigQuery, puis transférer la donnée de BigQuery vers Snowflake.

Peu d’efforts pour beaucoup de résultats

L’entreposage de données comporte beaucoup d’avantages pour votre entreprise, et les efforts et investissements nécessaires pour le faire sont bas. Si vous êtes une personne qui préconise la loi du 80/20 et qui aime calculer ses décisions sur le ratio entre les efforts et les résultats, lancez-vous!

Plus tôt vous commencez la collecte de données, plus tôt vous pourrez obtenir de l'information intéressante pour activer des stratégies SEO efficaces et durables.

Contactez vos experts en marketing et enclenchez le processus!